لم تعد تطبيقات الذكاء الاصطناعي مجرد أدوات للمساعدة في التعلم أو العمل أو الإبداع، بل بدأت تدخل تدريجياً في مشهد الجرائم الرقمية والجنائية، سواء كمحرّض غير مباشر أو كدليل رقمي تستخدمه السلطات لكشف المتورطين.

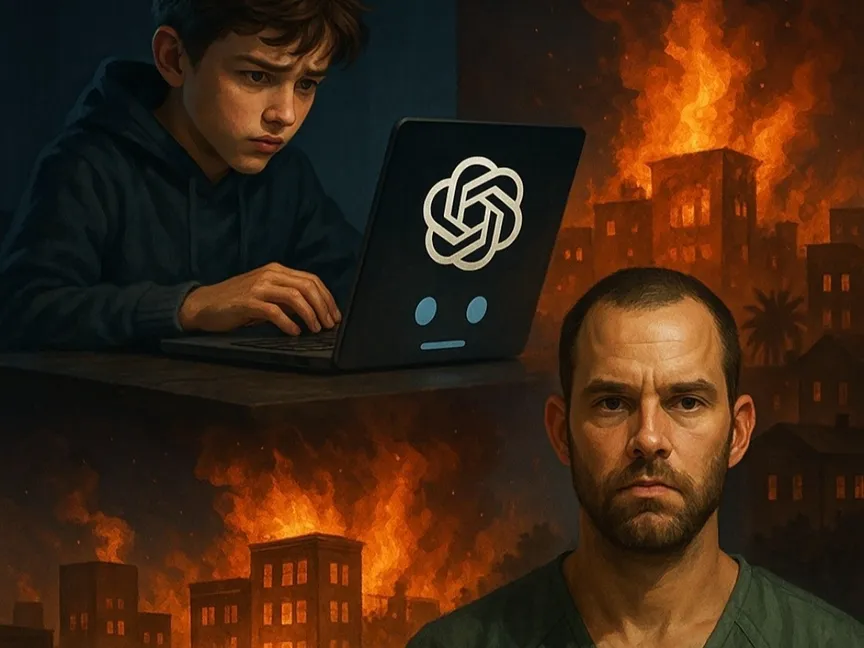

تعلّم فتى يبلغ من العمر 13 عاماً في مدينة دي لاند بولاية فلوريدا درساً قاسياً بشأن مخاطر الخصوصية في استخدام ChatGPT، بعدما أوقفته الشرطة لطرحه سؤالاً على الذكاء الاصطناعي بشأن كيفية قتل صديقه، بحسب موقع Phandroid.

وكان الفتى قد استخدم حاسوباً محمولاً وفّرته له المدرسة، يحتوي على برنامج مراقبة يُعرف باسم Gaggle، رصد الاستفسار فوراً وأبلغ السلطات، التي هرعت إلى مكانه وألقت القبض عليه خلال ساعات.

الطابع الودود الذي تتبعه روبوتات الدردشة بالذكاء الاصطناعي يخدع المستخدمين ويدفعهم إلى التعامل معها كأنها أصدقاء مقرّبون أو مستشارون موثوقون، إذ أن ChatGPT يجيب بنبرة دافئة ويبدو متفهماً وشخصياً، لكنه في النهاية مجرد برنامج حاسوبي، وليس معالجاً نفسياً ملزم بالسرّية، ولا صديقاً يحتفظ بالأسرار، بل آلة تعالج ما يُكتب لها. وفي حالات كثيرة، تُسجَّل تلك المحادثات وتُراقب أو تُبلّغ عنها.

ورغم أن هذا الحادث كُشف عبر برنامج مراقبة مدرسي، فإن المخاوف المتعلقة بخصوصية ChatGPT تتجاوز بيئة التعليم، إذ يمكن للشركات مراقبة استخدام موظفيها للأدوات الذكية، وللآباء الاطلاع على سجلات محادثات أبنائهم، كما يمكن لأجهزة إنفاذ القانون طلب الوصول إلى البيانات عند الحاجة. وهكذا، توهم واجهة المحادثة الودية المستخدمين بخصوصية غير موجودة فعلياً.

التحقيقات كشفت أن الفتى حاول تبرير تصرفه بأنه كان يمزح بعد خلاف مع أحد زملائه، لكن الشرطة أوضحت أن مثل هذه الأفعال لا تُعتبر مزاحاً في زمن المراقبة الذكية، حيث تُصنّف مثل هذه الاستفسارات كتهديدات خطيرة.

مأزق الخصوصية

تسلّط هذه الواقعة الضوء على فجوة جوهرية في فهم الناس لطبيعة التفاعل مع روبوتات الدردشة المدعومة بالذكاء الاصطناعي. فالإجابات الودودة والمساعدة التي يقدمها ChatGPT تخلق وهماً بوجود محادثة خاصة، بينما الواقع مختلف تماماً.

ولا تقتصر مخاطر الخصوصية على أجهزة المدارس، إذ يمكن لأي جهاز في بيئة عمل أو حاسوب مشترك أو شبكة خاضعة للرقابة أن يكشف مضمون المحادثات مع الذكاء الاصطناعي، فهذه التقنية قد تبدو شخصية، لكنها تخلو من أي حماية قانونية للسرّية. وينبغي للمستخدمين أن يدركوا أن كل طلب أو سؤال أو محادثة مع الذكاء الاصطناعي تُعامل كبيانات يمكن الوصول إليها أو مراجعتها أو استخدامها ضدهم.

"حريق كارثي"

وفي حادثة أخرى، أعلنت السلطات الأميركية توقيف رجل من ولاية فلوريدا يُدعى جوناثان ريندركنيخت بتهمة إشعال الحريق الكارثي الذي دمّر أجزاء واسعة من مناطق بلاية كاليفورنيا مطلع عام 2025، وأودى بحياة 12 شخصاً وإتلاف آلاف المنازل.

واللافت في القضية أن ChatGPT لعب دوراً محورياً في التحقيقات، فبحسب ما كشفته وزارة العدل الأميركية، استخدم المتهم التطبيق لسؤال مباشر: "هل سيتم اعتباري مسؤولاً إذا اشتعل حريق بسبب سيجارتي؟" ، وكان رد ChatGPT: "نعم".

لكن الأخطر أن الأجهزة الرقمية التي صادرتها السلطات من المتهم احتوت على صورة أنشأها عبر ChatGPT تُظهر غابة مشتعلة وحشوداً تهرب من النار، وهي صورة أنشأها قبل الحريق بأشهر.

وأظهرت الوثائق القضائية أن المتهم استخدم التطبيق لتخيُّل مشاهد الحريق، وأن هذه البيانات الرقمية ساعدت المحققين في إثبات صلته المباشرة بالحادث. ويواجه ريندركنيخت الآن تهمة "تدمير الممتلكات عن طريق الحرق"، وهي جريمة فيدرالية قد تصل عقوبتها إلى السجن 20 عاماً.

تكنولوجيا بلا وعي

وعلى الرغم من اختلاف الواقعتين، لكنهما تكشفان عن اتجاه جديد في العلاقة بين الذكاء الاصطناعي والجريمة. ففي الأولى، كان ChatGPT أداة استُخدمت في سياق تهديد، بينما في الثانية أصبح جزءاً من أدلة الإدانة نفسها.

وأكد الخبراء أن الخطر لا يكمن في التكنولوجيا ذاتها، بل في طريقة استخدامها وسوء فهم المستخدمين لحدودها.

فالتفاعل مع الذكاء الاصطناعي ليس محادثة خاصة، بل نشاط رقمي يُسجَّل ويُخزَّن ويمكن الرجوع إليه عند الضرورة القانونية.

ومع تزايد اعتماد الأفراد على تطبيقات الذكاء الاصطناعي في مختلف جوانب حياتهم، رأى محللون أن الحاجة باتت ملحّة لوضع أطر قانونية واضحة تُنظّم استخدام هذه الأدوات وتحمي المستخدمين من عواقب سوء الاستخدام أو التورط في جرائم رقمية دون قصد.