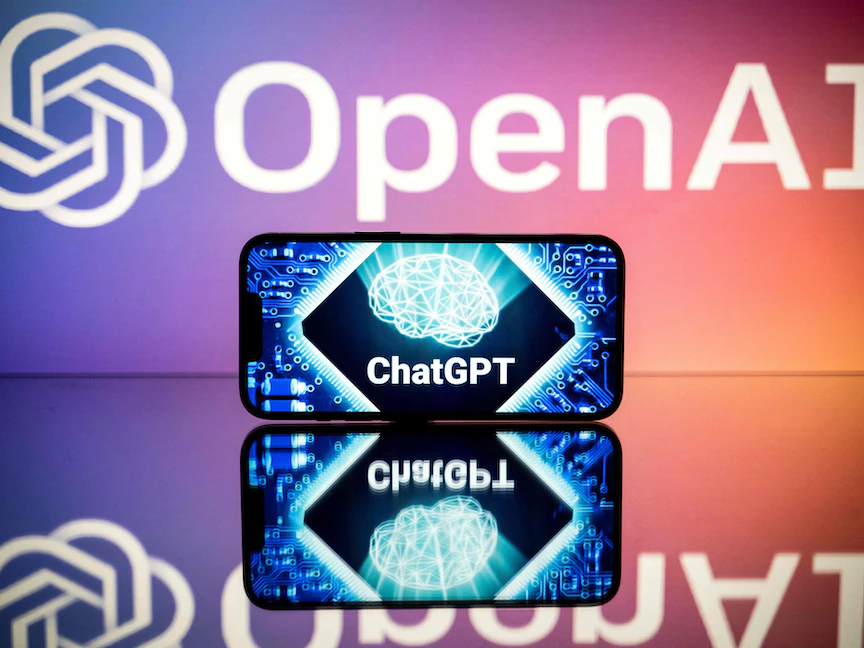

أفادت دراسة نشرتها دورية الجمعية الأميركية لطب الأشعة "راديولوجي"، بأن أحدث إصدارات برنامج المحادثة باستخدام الذكاء الاصطناعي "ChatGPT" اجتاز بنجاح اختباراً يُشبه تماماً اختبار المجلس الأميركي للأشعة.

واختبار المجلس الأميركي للأشعة، الذي يُطلق عليه "البورد الأميركي"، هو أحد الامتحانات التي تُقيّم معرفة وكفاءة وخبرة الأفراد، الذين يسعون للحصول على شهادة أو تخصص في مجال الأشعة.

وتدار الاختبارات عادة من قبل المنظمات المهنية أو المجالس المسؤولة عن تنظيم واعتماد أخصائيي الأشعة، ويكون الغرض من الاختبار تقييم فهم المرشح لموضوعات الأشعة المختلفة، بما في ذلك أساليب التصوير، وعلم التشريح، وعلم الأمراض، والتفسير الشعاعي، والمهارات الإجرائية، وإدارة المريض.

و"CHAT GPT" عبارة عن أداة محادثة للذكاء الاصطناعي، تستخدم نموذج التعلّم العميق للتعرف على الأنماط والعلاقات بين الكلمات في بيانات التدريب الواسعة الخاصة به لإنشاء استجابات شبيهة بالبشر بناءً على موجه، ولكن نظراً لعدم وجود مصدر مُوحد في بيانات التدريب الخاصة به، يمكن للأداة إنشاء ردود غير صحيحة من الناحية الواقعية.

وقال المؤلف الرئيسي للدراسة راجيش بهايانا، وهو أخصائي أشعة في جامعة "ميديكال إميجنبج" بمدينة تورنتو الكندية، إن استخدام نماذج اللغة الكبيرة مثل (ChatGPT) "ينفجر وسيزداد"، مشيراً إلى أن البحث الجديد "يوفر نظرة ثاقبة لأداء (ChatGPT) في سياق الأشعة، ويسلط الضوء على الإمكانات المذهلة لنماذج اللغة الكبيرة، إلى جانب القيود الحالية التي تجعلها غير موثوقة".

وأشار بهايانا إلى أن "ChatGPT" هو أحد أكثر تطبيقات المستهلك نمواً في التاريخ، ويتم دمج برامج الدردشة المماثلة في محركات البحث الشهيرة مثل "جوجل" التي يستخدمها الأطباء والمرضى للبحث عن المعلومات الطبية.

تقييم أداء "ChatGPT"

ولتقييم أداء تلك الأداة في أسئلة امتحان "بورد" الأشعة، واستكشاف نقاط القوة والقيود، اختبر بهايانا لأول مرة نسخة GPT-3.5، وهو الإصدار الأكثر استخداماً حالياً.

واستخدم الباحثون 150 سؤالاً متعدد الخيارات صممت لتتناسب مع أسلوب ومحتوى وصعوبة امتحانات الكلية الملكية الكندية، والمجلس الأميركي للأشعة. وتم تقييم أداء ChatGPT بشكل عام وبحسب نوع السؤال والموضوع.

وجد الباحثون أن ChatGPT أجاب على 69% من الأسئلة بشكل صحيح (معدل نجاح 104 من 150)، بالقرب من درجة النجاح البالغة 70% التي تستخدمها الكلية الملكية في كندا.

وكان أداء النموذج جيداً نسبياً في الأسئلة التي تتطلب مستوى أدنى من التفكير (معدل إجابات صحيحة 84% أو 51 من 61)، لكنه واجه صعوبة في الأسئلة التي تتضمن تفكيراً عالي المستوى (معدل إجابات صحيحة 60% أو 53 من 89).

وبشكل أكثر تحديداً، واجهت الأداة صعوبة مع الأسئلة ذات الترتيب الأعلى التي تتضمن وصف نتائج التصوير (معدل إجابات صحيحة 61% أو 28 من 46)، والحساب والتصنيف (معدل إجابات صحيحة 25% أو 2 من 8)، وتطبيق المفاهيم (معدل إجابات صحيحة 30% أو 3 من 10).

ولم يكن أداؤها الضعيف في أسئلة التفكير العليا مفاجئاً نظراً لافتقارها إلى التدريب المسبق الخاص بالأشعة.

بعد ذلك، اختبر الباحثون إصدار GPT-4، الذي تم تطويره في مارس 2023 في شكل محدود للمستخدمين المدفوعين.

وفي دراسة متابعة، أجاب GPT-4 على 81% (121 من 150) من الأسئلة نفسها بشكل صحيح، متفوقاً على GPT-3.5 وتجاوز عتبة النجاح البالغة 70%.

وكان أداء GPT-4 أفضل بكثير من GPT-3.5 في أسئلة التفكير العليا (81%)، وبشكل أكثر تحديداً تلك التي تتضمن وصف نتائج التصوير (85%) وتطبيق المفاهيم (90%).

وتشير النتائج إلى أن قدرات التفكير المتقدمة المحسنة لإصدار GPT-4 تترجم إلى أداء محسن في سياق الأشعة.

فهم متطور

وأظهرت النسخة الجديدة فهماً محسناً للسياق للمصطلحات الخاصة بالأشعة، بما في ذلك أوصاف التصوير، وهو أمر بالغ الأهمية لتمكين التطبيقات النهائية في المستقبل.

لم يُظهر GPT-4 أي تحسن في أسئلة التفكير ذات المستوى الأدنى (80% مقابل 84%)، وأجاب على 12 سؤالاً بشكل غير صحيح، فيما أجاب GPT-3.5 بشكل صحيح، ما أثار أسئلة تتعلق بموثوقيته في جمع المعلومات.

وقال الباحثون إنهم فوجئوا في البداية بإجابات "ChatGPT" الدقيقة والواثقة على بعض أسئلة الأشعة الصعبة، وفوجئوا أيضاً ببعض التأكيدات غير المنطقية وغير الدقيقة "فنظراً لكيفية عمل هذه النماذج، لا ينبغي أن تكون الردود غير الدقيقة مفاجئة بشكل خاص".

وأشار الباحثون إلى أن الميل الخطير لـChatGPT لإنتاج استجابات غير دقيقة أقل شيوعاً في GPT-4، لكنه لا يزال يحد من قابلية الاستخدام في التعليم الطبي والممارسة في الوقت الحالي.

وأظهرت الدراسة أن "ChatGPT" يستخدم لغة واثقة باستمرار، حتى عندما تكون غير صحيحة. وهو أمر خطير بشكل خاص إذا تم الاعتماد عليه فقط للحصول على المعلومات، خاصة بالنسبة للمبتدئين الذين قد لا يتعرفون على الاستجابات الواثقة غير الصحيحة.

اقرأ أيضاً: