حدّد الاتحاد الأوروبي في قانونه الجديد لتنظيم استخدام الذكاء الاصطناعي AI Act، والذي يعد الأول من نوعه عالمياً، مجموعة من المجالات التي اعتبر أن استخدامها يمثل خطورة عالية.

ودخل القانون الأوروبي لتنظيم استخدام الذكاء الاصطناعي حيز التنفيذ، الخميس، إلا أن عدداً من بنوده سيبدأ العمل بها خلال العامين المقبلين، كفترة سماح للشركات لإجراء التغييرات اللازمة والالتزام بالقانون.

ووفقاً لما ورد في الملحق الثالث للقانون الأوروبي الجديد، فإن استخدامات الذكاء الاصطناعي عالية الخطورة تتمثل في أشكال عدة.

تحليل البيانات البيومترية

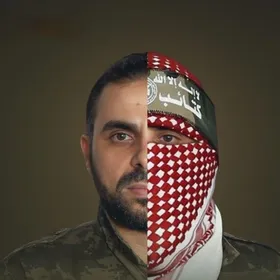

وضع الاتحاد الأوروبي تحليل بيانات مواطني الدول الأعضاء البيومترية، على قمة استخدامات الذكاء الاصطناعي عالية الخطورة، خاصة ما يتعلق بأنظمة تحليل البيانات عن بعد، مثل تحليل وقراءة والتعرف على الوجوه عبر أنظمة المراقبة.

وكذلك تضمن هذا القطاع استخدام الذكاء الاصطناعي للتصنيف على أساس بيومتري، من خلال جمع وتحليل سمات مختلفة من وجوه وملامح أجسام الأشخاص، إلى جانب استخدام أنظمة تحليل المشاعر.

ولكن هذا البند من القانون استثنى أنظمة تأكيد الهوية عبر التعرف على الوجوه وملامحها.

البنية التحتية

ويعد استخدام الذكاء الاصطناعي كمكون الأمان والحماية داخل مرافق البنية التحتية المختلفة، أحد أشكال الاستخدامات عالية الخطورة للتقنيات الذكية الحديثة، مثل إدارة وتشغيل البنية التحتية الرقمية، وحركة المرور، وأنظمة إمداد المياه والغاز، ومحطات الكهرباء والتدفئة.

التعليم والتدريب المهني

اهتم المشرعون الأوروبيون بتقنين استخدام الذكاء الاصطناعي في بيئات العمل والتعليم، واعتبروا أن استخدامه في هذه المجالات يعتبر "عالي الخطورة".

ومن بين هذه الاستخدامات، الاعتماد على أنظمة ذكية لقبول شخص ما ليحصل على فرص التعليم أو التدريب المهني، وكذلك تحديد مستوى التعليم المناسب الذي سيتلقاه أو ما سيكون قادراً على الوصول إليه، إلى جانب مراقبة ورصد سلوكه في المؤسسات عبر مختلف المستويات العلمية والوظيفية.

إدارة بيئة العمل

أدرج القانون الجديد استخدام الذكاء الاصطناعي في مختلف نواحي بيئة العمل كأحد الاستخدامات عالية الخطورة، مثل استخدامه في عملية إعداد وكتابة ونشر إعلانات الوظائف الشاغرة، وعملية فرز وتصفية السير الذاتية المقدمة، وتقييم المتقدمين.

إلى جانب مراحل التوظيف، فإن القانون ركز أيضاً على مدى خطورة استخدام الذكاء الاصطناعي في تقييم أداء الموظفين، ووضع أسس ترقيتهم أو تسريحهم، إلى جانب تقسيم مهام العمل على أساس السلوك الفردي أو الصفات أو الخصائص الشخصية، ومراقبة وتقييم الأداء وسلوك الأشخاص في علاقات العمل.

الخدمات العامة والخاصة

سلّط القانون الجديد الضوء على مدى الخطورة الفائقة لأنظمة الذكاء الاصطناعي التي تحدد مدى أحقية الأشخاص في الحصول على بعض الخدمات العامة والخاصة.

ويندرج تحت ذلك ما يتعلق بأحقية وأهلية الأشخاص للحصول على المساعدات والخدمات العامة الأساسية، بما في ذلك خدمات الرعاية الصحية، بالإضافة إلى منح هذه الفوائد والخدمات أو تخفيضها أو إلغائها أو استردادها.

كما صنّف استخدام الذكاء الاصطناعي في تقييم جدارة الأشخاص للحصول على المساعدة خلال الطوارئ "عالي الخطورة"، ويتضمن ذلك أنظمة تقييم وتصنيف مكالمات الطوارئ، وأنظمة تحديد الأولويات في إرسال خدمات الاستجابة الطارئة، بما في ذلك الشرطة ورجال الإطفاء والإسعاف، وأيضاً أنظمة فرز الحالات المرضية الطارئة في مجال الرعاية الصحية.

أما على مستوى الخدمات الخاصة، فإن الخطورة صُنفت بأنها فائقة مع استخدام الذكاء الاصطناعي لتحديد مدى الجدارة الائتمانية للأشخاص أو تحديد درجة ائتمانهم، وتقييم المخاطر وتسعير التأمين على الحياة والصحة.

إنفاذ القانون

لم يستثني المشرعون الأوروبيون سلطات إنفاذ القانون في قانونهم الجديد، إذ اعتبروا أن استخدام الذكاء الاصطناعي في هذا المجال عالي الخطورة، في حالة تم استخدامه من قبل أو نيابة عن سلطات إنفاذ القانون، أو من قبل مؤسسات وهيئات ومكاتب ووكالات الاتحاد الأوروبي، لتقييم خطر أن يصبح شخص ما ضحية للجرائم.

وكذلك عند استخدامه كأدوات في التحقيقات والبحث، كأجهزة كشف الكذب، وكذلك لتقييم موثوقية الأدلة أثناء التحقيق أو المقاضاة خلال الجرائم الجنائية، ولتقييم السمات والخصائص الشخصية أو السلوك الجنائي السابق للأشخاص أو الجماعات.

الهجرة واللجوء ومراقبة الحدود

جاء استخدام الذكاء الاصطناعي لتنظيم دخول المهاجرين واللاجئين إلى دول الاتحاد الأوروبي ضمن الاستخدامات عالية المخاطر، ويندرج تحته استخدام الأنظمة الذكية كأجهزة لكشف الكذب أو أدوات مشابهة، وكذلك رصد الهجرة غير النظامية، والمخاطر الصحية التي قد يشكلها شخص ينوي الدخول أو دخل بالفعل إلى إقليم أحد الدول الأعضاء.

ومن الأنظمة عالية المخاطر، تلك المستخدمة في فحص طلبات اللجوء أو التأشيرات أو تصاريح الإقامة، والأنظمة الخاصة بالنظر في الشكاوى المرتبطة بأهلية الأشخاص المتقدمين للحصول على وضع معين، بما في ذلك التقييمات المتعلقة بموثوقية الأدلة وصحتها.

وتضمنت الاستخدامات عالية الخطورة أيضاً الأنظمة الذكية لإدارة الهجرة واللجوء ومراقبة الحدود، بهدف اكتشاف أو تحديد هوية الأشخاص، بينما تم استثناء أنظمة الذكاء الاصطناعي الخاصة بالتحقق من وثائق السفر.

القضاء والانتخابات

تشمل الاستخدامات عالية الخطورة لأنظمة الذكاء الاصطناعي، مساعدة القضاة في البحث وتفسير القوانين وتطبيقها على قضايا محددة، أو استخدام هذه الأنظمة في آليات تسوية النزاعات.

وتضمنت الاستخدامات عالية الخطورة، وفقاً للقانون الجديد، استخدام الذكاء الاصطناعي للتأثير على نتائج الانتخابات أو الاستفتاءات أو سلوك التصويت للأفراد.

مع ذلك، يتم استثناء الأدوات المستخدمة لأغراض تنظيمية أو لوجستية للحملات السياسية، حيث لا يتعرض الأشخاص الطبيعيون مباشرة لنتائج هذه الأدوات.

سياق تنظيمي

وتضمنت المادة السادسة من قانون الهيكل التنظيمي كيفية اعتبار حالة محددة على أنها استخدام "عالي الخطورة"، وأيضاً في حال كان الذكاء الاصطناعي عنصر أمان في منتج ما، وغيرها. ويتطلب ذلك إجراء تقييم من قبل جهة خارجية قبل طرح النظام في السوق أو تشغيله.

كما أن هناك أنظمة ذكاء اصطناعي تُعتبر دائماً ذات أخطار عالية، إلا إذا كانت لا تشكل خطراً كبيراً على الصحة أو السلامة أو الحقوق الأساسية للأوروبيين.

كذلك يجب على مقدمي هذه الأنظمة توثيق تقييماتهم وتقديمها عند الطلب.

وستقدم المفوضية الأوروبية إرشادات وأمثلة على الأنظمة ذات المخاطر العالية وغيرها، قبل حلول 2 فبراير 2026.